原创不易 请随手点击关注

本文由Rehoo团队Leery原创,无授权禁转!(图片来自网络)

图片来自网络

人工智能为我们提供了一个机会,在日常生活中可以多次扩大服务和技术的整合。但直到最近,技术的复杂程度仍然存在重大障碍。如果没有完全理解语音中的情感以及AI如何捕获和识别它,语音助手(语音助理,智能汽车,机器人和具有语音识别功能的所有AI)将继续缺乏个性的关键组成部分。这种障碍使AI助手难以像人类助手那样完全理解并与人类情感接触。

然而目前这逐渐开始发生变化。技术的快速发展使工程师能够对这些语音助理进行编程,更好地了解某人的声音情绪以及与这些情绪相关的行为。我们越了解这些细微差别,我们的AI系统将变得越敏捷和情感智能化。

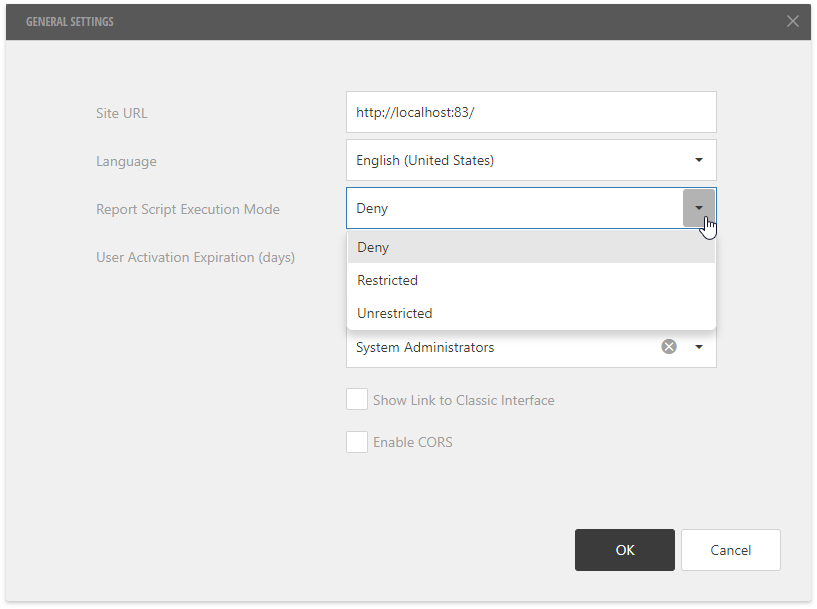

人类不仅仅是“快乐”,“悲伤”或“愤怒”。我们是语言,动作和音调所代表的频谱中数十种情感的表现。人们有时很难在谈话中接受所有这些线索,更不用说机器了。但是,通过正确的方法和关于如何体验情感的分析地图,可以开始教这些机器如何识别这些信号。可以根据以下图形显示人类情感的不同色调:

图片来自网络

结果是在爱情,喜悦,惊讶,愤怒,悲伤和恐惧之下分类了超过50种个人情感 。这些情绪中的许多都意味着特定的行为并且具有高度的情境,这意味着很难区分。这就是为什么情感AI在为人类操作员分配情绪状态时识别两组模式非常重要的原因。

认识到声音中的情感

无论先进技术如何发展,它仍处于早期阶段。聊天机器人,语音助理和自动服务界面经常缺乏识别您生气或不安的能力,这种差距使AI无法在客户服务和销售等方面发挥更重要的作用。

问题在于话语,人工智能可以量化和评估的对话部分还不够。它不是关于我们说什么,而是关于我们如何说它。已经进行的研究表明,你的声音的语调或语调远比你说的话更能说明你的情绪和精神状态。

情绪韵律或语音中的语调可以通过多种方式传达:音量,速度,音色,演讲中使用的语气停顿。考虑一下当某人讽刺时你如何识别。这不是单词,它是某些单词的延伸和声明的一般基调。更进一步的是韵律影响言语的不同方式:实施的单词,短语和语气,甚至是伴随语音的非语言声音。

为了更好地理解与语言或语义信息无关的语音数据,行为信号处理是一种新的技术领域,它在检测人类语音编码的信息。结合最佳的AI工程技术和行为科学,这个新领域在充分解释人类的互动和语音沟通的基线。

它的工作原理是收集一系列行为信号,一些是明显的,另一些则不那么明显。它利用从语音,文本和元数据中的数据中提取的情绪,行为和感知思想,想法和信念,以识别用户识别情绪状态。他们的情绪来自数十种不同的来源。这需要一个能够同时观察,通信和评估来自多个来源的数据并以实物形式进行响应的系统。

设计机器和人类之间更好的接口

企业正在利用这项新技术提供的见解,更好地评估和利用其组织中的非结构化数据。通话录音,聊天记录和支持票据现在提供了一个基础,大型组织可以更好地了解客户在接触时的感受以及这些情绪最终如何影响他们的决策。

这开辟了一条了解客户互动背景的新途径。无论是客户服务还是销售,个人都会与他们互动,然后记录他们的感受或反应。这需要以结构化格式编写,以便将来进一步评估。

图片来自网络

今天的人工智能系统可以引用主要数据,客户和潜在客户提供的实际响应,以便更好地了解他们需要什么以及他们为什么需要它。这种洞察力比以往任何时候都要强大得多,并且还在不断发展。

因此,AI助手的未来是光明的。企业不仅能够更好地理解和响应消费者需求;这些机器也已经在全球各地的家庭和办公室中实施。智能手机和个人语音助理设备将对驱动人类响应的背景和行为产生更细微的理解。

人类声音中的情感含义正在以前所未有的方式进行解码和映射,并为下一代情感智能AI提供基础。这是人机交互的未来,它的发展速度比以往任何时候都快。