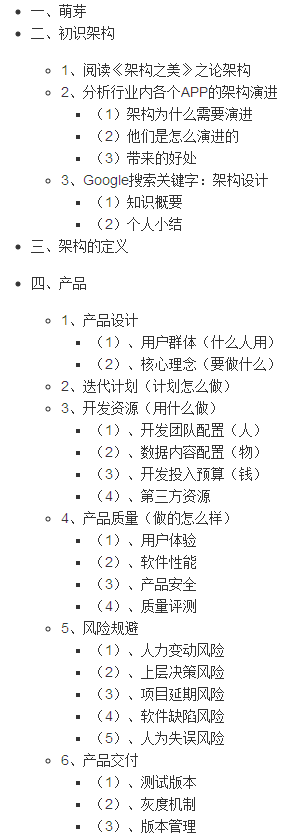

我玩用Scikit - 学习(sklearn)一VS-所有Logistic回归分类。 我有一个大的数据集是一气呵成运行所有太慢; 我也想学习学习曲线作为训练所得。

我想用批处理梯度下降训练我的分类中,比方说,500个样品批次。 是否有使用sklearn做到这一点的一些方法,或者我应该放弃sklearn和“滚我自己”?

这是我到目前为止有:

from sklearn.linear_model import LogisticRegression

from sklearn.multiclass import OneVsRestClassifier

# xs are subsets of my training data, ys are ground truth for same; I have more

# data available for further training and cross-validation:

xs.shape, ys.shape

# => ((500, 784), (500))

lr = OneVsRestClassifier(LogisticRegression())

lr.fit(xs, ys)

lr.predict(xs[0,:])

# => [ 1.]

ys[0]

# => 1.0

也就是说,它正确地识别训练样本(是的,我知道这将是更好地与新的数据来评价它 - 这仅仅是一个快速烟雾测试)。

再批梯度下降:我没有尽可能创造学习曲线得到,但可以在一个简单的运行fit反复训练数据的后续子集? 或者是有一些其他的功能,分批培训? 文档和谷歌都对此事相当沉默。 谢谢!