越来越强大的AI模型正在改变这个世界。但这背后的成本并不便宜。以中国的数据为例,全国40万个数据中心,每年总体耗电量超过1000亿度,这相当于三峡和葛洲坝水电站1年发电量的总和。

近日,著名的AI研究机构艾伦AI研究所(AI2)发布了一份新的立场文件(Position Paper),呼吁业内在评估AI研究时应该更加重视能效,在开发、训练和运行模型时,与速度、准确性等指标一并列出“成本标签”。AI2 首席执行官 Oren Etzioni 表示,时代正在发生变化,“能源密集型”的AI研究产生的碳排放愈发令人担忧。

图丨名为“绿色AI”的立场文件(来源:arxiv)

业内是不是需要一个深度学习效率评估标准来扭转方向仍待讨论,但AI2的这次呼吁并不是个例。

今年初到现在,明显有越来越多的研究人员对AI研究尤其是深度学习不断增长的成本发出了警告。不久前在北京举办的鲲鹏计算产业发展峰会上,中国科学院院士梅宏表示,云计算、AI对绿色计算提出巨大需求。

而最近在旧金山举行的一次会议上,应用材料公司CEO加里·迪克森(Gary Dickerson)更是给出了一个大胆的预测:在材料、芯片制造和设计方面缺乏重大创新的情况下,到2025年,数据中心的人工智能工作量将占世界用电量的10%。要知道,目前广为诟病的比特币挖矿每年消耗电量超过20亿瓦,也只是大概相当于全球电量的0.5%而已。

Etzioni强调,在能源需求方面,不希望人工智能研究成为翻版的比特币挖矿活动。

图丨 艾伦AI研究所首席执行官 Oren Etzioni (来源:AI2)

“不计成本”的研究思路屡遭批判

AI计算的能耗增长首先来自越来越复杂的AI模型的出现,颇为讽刺的是,诸如深度学习等热门AI技术,其灵感来自于人类的大脑,但人的大脑其实是非常节能的。

以自然语言处理为例,今年 6 月,一项研究更是指出,开发大规模的自然语言处理模型会产生令人震惊的碳排放量。

那篇提交到自然语言处理顶会ACL 2019的论文显示,Transformer、GPT-2、ELMo、BERT这4个热门的语言处理深度神经网络,其训练过程的碳排放不亚于一辆汽车从生产到报废产生的碳排放量。

图丨NLP 4大顶尖模型的训练用时、能耗效率和碳排放(来源:ACL 2019)

以谷歌开发的Transformer为例,在不使用神经架构检索(NAS)的情况下,训练Transformer所需的时间是84小时,而使用NAS的情况则花费了27万小时以上。上述4个神经网络中,耗电量最大的是使用NAS时的Transformer,二氧化碳排放量为284吨。这是平均轿车从制造到耐用年数的使用和废弃的全过程排出的二氧化碳量(约57吨)的约5倍。

更早时候,谷歌将工业界新宠AutoML 的思想应用到NLP领域,找到了进化版的Transformer,其中,用于英语到德语翻译的BLEU分数提高了0.1,却花费了3.2万TPU小时,云计算费高达15万美元。

这一趋势出现的原因之一在于,近年来,企业研究实验室投入深度学习的计算能力大幅提升,业界尤其是头部公司的研究团队在推动技术发展的同时,几乎不怎么考虑能耗成本,简而言之,不差钱。这种突破性项目所耗费的资源已经和普通项目的不在一个量级。于是我们看到,总会有一些排行榜不断庆祝新的记录突破,但他们很少提及这些成绩所带来的成本。殊不知,性能的线性增长背后,其实是资源的指数增长。

此前Open AI发表的一项研究就显示,每三到四个月,训练这些大型模型所需的计算资源就会翻一番(相比之下,摩尔定律有18个月的倍增周期)。2012至2018年间,深度学习前沿研究所需的计算资源更是增加了30万倍。

图丨2012年以来,最大规模人工智能模型中所用计算量呈指数级增长,3.5个月的时间翻一倍。自201

初创公司将首先受益于“绿色AI”

现在,AI2 首席执行官 Oren Etzioni 就在这份最新报告中呼吁,业内刊物和会议的审稿人应该奖励那些提高效率和性能的研究人员。对于整个行业来说,还需要更加从上至下地设计新的机制保证资源成本的耗费得到更多关注。

他认为,AI研究人员从现在开始一同公布培训模型的财务和计算成本以及他们的性能成果,提高实现性能提升所需资源的透明度,这将能激励开发高效节能的机器学习算法。

Oren Etzioni 提出,可以给AI研究规定一个“成本标签”:如将达到特定结果所需的浮点运算(FPO)作为研究论文的常规部分。

但是,仅仅是FPO这一项指标还无法解决所有问题。“我们已经看到在AI模型开发中持续升级的惊人能耗,公开这些能耗成本会是科技界的一个持续的话题”,他说。

关注能耗指标不仅仅是从环境的角度考虑的,它对该领域的多样性发展和技术进步也有影响。

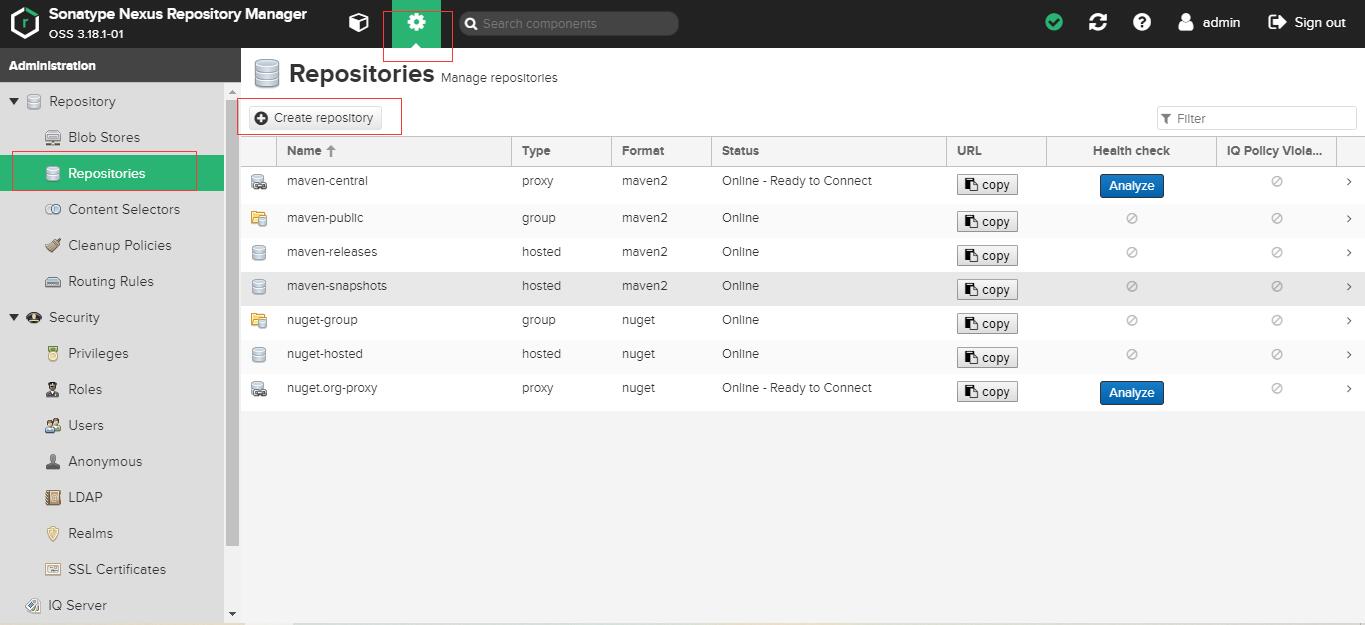

图丨AI2 团队从几个顶会中抽取了一定数目的论文,结果显示研究人员对准确率的关注度要大于效率(来源:

逻辑在于,那些以资源耗费为首要代价的显著成果,在AI实验室中可以获得更多的关注和成长空间,但历史表明,更有持久力的创新往往是在基于有限的资源上产生的。密集地消耗资源,可能会限制住实验室中的研究在资源有限的现实世界中施展拳脚,同时又将该领域的发展导向短期见效的成果,而不是更有利于公众的相关技术的长期进展。

“这里有一个重要的包容性问题。如果你需要比如10亿美元才能踏入前沿的人工智能研究,那么可能来自新兴经济体的人们,甚至学生、学者和创业公司,都会被排除在外”,Etzioni 表示,希望整个AI社区能够更多地意识到这种权衡。他认为,这不是一个非此即彼的问题,“我们只是想在这个领域取得更好的平衡。”

尤其对于一些初创企业来说,投资更高效更节能的算法,可以帮助他们从有限的资源中挤出更多利润,并产生其他收益。当然在行业的实践上,已经有一些公司意识到AI计算能效的重要性,而非单单追求依赖硬件的算力野蛮生长。

前几年关于芯片算力这一概念的讨论,多认为理论上的计算峰值就是算力,但现在,业内有观点指出,在讨论算力的演进时应该少关注器件利用率。

在一场AI芯片论坛中,地平线联合创始人兼副总裁黄畅就提出了一个“定义真实的AI芯片性能”的说法。

(来源:DeepTech)

据介绍,传统芯片性能指的是PPA,包括Power、Performance、Aera(性能、功耗、面积),即一秒钟执行多少指令,在AI芯片上则是讨论每瓦有多少AI计算,比较主流的指标是TOPS/Watt和TOPS/$。但算法不断演进,器件的利用率由架构和编译器决定,架构负责把算法转化为相对架构而言最优的质量、序列和执行模式。一个保证能效的做法是,算法+芯片联合优化,兼顾计算架构和算法设计。

他认为未来还会有巨大的AI计算需求。“举个例子,Google前段时间训练的非常厉害的模型,进一步用NAS的技术,调用上千台GPU跑了两个月找到很好的结构,把机器翻译的模型推到极致。如果把模型部署出去进行推理,随着时间的增长,它的能耗是百倍、千倍的增长。我们不能忽视享受GPU的集群训练、推理背后巨大的能源消耗……做AI的企业,不管是做算法、应用、芯片的都要承担一些社会责任”,他说。

下一个“吃电巨兽”市场,低能耗的成本优势或成竞争决胜点

除了日益复杂的AI模型以外,另一个推动AI计算走向能源密集的因素是,训练 AI 模型的信息组合也在发生转变。

与文本和音频信息相比,视频和其他图像信息占比正在不断增加,尤其在5G、边缘计算铺开之后,可视数据对算力的需求更大,所以能耗也相对高一些。加之无人车和嵌入其他智能设备的传感器等产品的兴起,训练AI模型需要的信息也更多,5G网络也会让数据中心之间的传输更加简单。

这也意味着,接下来,承载大数据以及大量AI计算的数据中心,很可能成为一只新的“吃电巨兽”。

仅仅以国内的数据中心建设为例,现在的数据中心已经有了惊人的耗电量。据《中国数据中心能耗现状白皮书》显示,在中国有40万个数据中心,每个数据中心平均耗电25万度,总体超过1000亿度,这相当于三峡和葛洲坝水电站1年发电量的总和。如果折算成碳排放则大概是9600万吨,这个数字接近目前中国民航年碳排放量的3倍。

但国家的要求是,到2022年,数据中心平均能耗基本达到国际先进水平,新建大型、超大型数据中心的PUE(电能使用效率值,越低代表越节能)达到1.4以下。而且北上广深等发达地区对于能耗指标控制还非常严格,这与一二线城市集中的数据中心需求形成矛盾,除了降低PUE,同等计算能力下服务器节能是重要解决方案之一。未来的服务器市场,大量的高能耗老旧设备将会被一一淘汰,低能耗的成本优势或将成为这一轮数据中心建设潮竞争的决胜点。

国内一家AI初创公司硬件业务部门则对 DeepTech 表示,在整个AI计算的过程中,与碳排放直接相关的,就是电力消耗问题,电力消耗又与使用什么样的处理器相关;另外就是在同样处理器的情况下,使用什么样的算法以减少服务器数量,从这两种情况去解决能耗问题。

由此出发,如果从算法的角度入手,应该秉承的理念是在合适的场景下用合适的算法去解决它。

其次就是算法和异构计算的配合,算法芯片的协同进化程度越高,就可以减少实际部署时服务器的数量,如此可以达到部分缓解AI计算碳排放的效果。

当然,最值得期待的还是一众正在酝酿中的新型微芯片。许多初创公司以及英特尔、AMD等大公司目前正在研发能通过光子学等新方法使用极少能耗就能驱动神经网络的半导体。

但也有人认为,AI对未来的大规模计算和能源需求不会有明显的增长。落基山研究所(Rocky Mountain Institute)高级研究员的特别顾问乔纳森·库梅的态度就比较乐观,他表示,虽然AI相关领域势头正盛,不过未来几年数据中心能耗仍会相对平稳。

这种莫衷一是的看法也表明,行业在AI对未来的大规模计算和能源需求的最终影响上仍未达成共识。有点讽刺的是,监测AI能耗可能还要靠AI本身。DeepMind 的AI技术就在这个方向上实现了业务收入,他们运用AI技术帮助谷歌数据中心降温,据称已经帮助谷歌降低了40%的冷却费用。