我想编写一个简单的网络蜘蛛或者只是使用wget下载从谷歌学术PDF结果。 这实际上是一个相当漂亮的方式来获得研究论文。

我已阅读计算器以下页面:

使用wget和限制抓取链接的总数抓取网站

如何做网络蜘蛛不同于Wget的的蜘蛛?

从网站上下载的所有PDF文件

如何下载使用wget网站的所有文件(而不是HTML)?

最后一页可能是最鼓舞人心的是。 我曾尝试使用wget作为建议此 。

我的谷歌学术搜索结果页面是这样 ,但没有被下载。

鉴于我的webspiders的了解程度是最小的,我应该怎么做才能让这一切成为可能? 我也知道写一个蜘蛛可能是非常复杂的,是一个项目,我可能不想承担。 如果可以使用wget ,这将是绝对真棒。

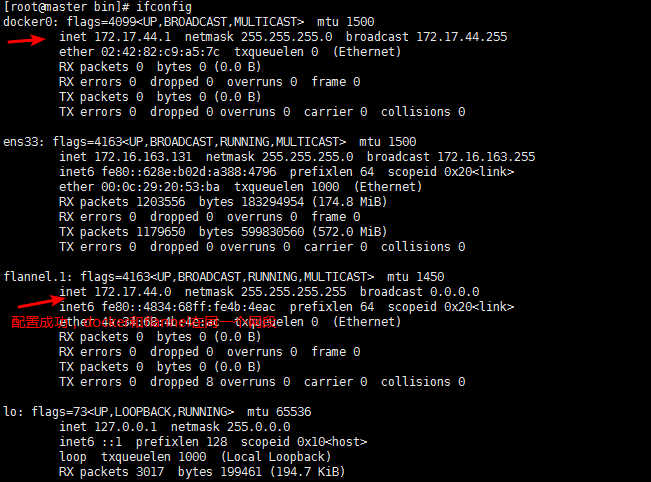

wget -e robots=off -H --user-agent="Mozilla/5.0 (X11; U; Linux i686; en-US; rv:1.9.0.3) Gecko/2008092416 Firefox/3.0.3" -r -l 1 -nd -A pdf http://scholar.google.com/scholar?q=filetype%3Apdf+liquid+films&btnG=&hl=en&as_sdt=0%2C23

有几件事情需要注意:

- 在搜索查询PDF格式:使用filetyle的

- 递归的一个水平

- -A PDF为只接受PDF文件

- -H跨越主机

- -e机器人=关闭和使用--user代理将确保最佳结果。 谷歌学术拒绝一个空白的用户代理和PDF库可能不允许机器人。

当然,限制,这将只命中结果的第一页。 你可以扩大递归的深度,但这会像脱缰的野马,并采取永远。 我会建议使用的类似组合美丽的汤和wget子进程,这样就可以分析和战略性遍历搜索结果。