下面是我的蜘蛛的代码,

class Blurb2Spider(BaseSpider):

name = "blurb2"

allowed_domains = ["www.domain.com"]

def start_requests(self):

yield self.make_requests_from_url("http://www.domain.com/bookstore/new")

def parse(self, response):

hxs = HtmlXPathSelector(response)

urls = hxs.select('//div[@class="bookListingBookTitle"]/a/@href').extract()

for i in urls:

yield Request(urlparse.urljoin('www.domain.com/', i[1:]),callback=self.parse_url)

def parse_url(self, response):

hxs = HtmlXPathSelector(response)

print response,'------->'

在这里,我想在href链接与基础链路相结合,但我得到了下面的错误,

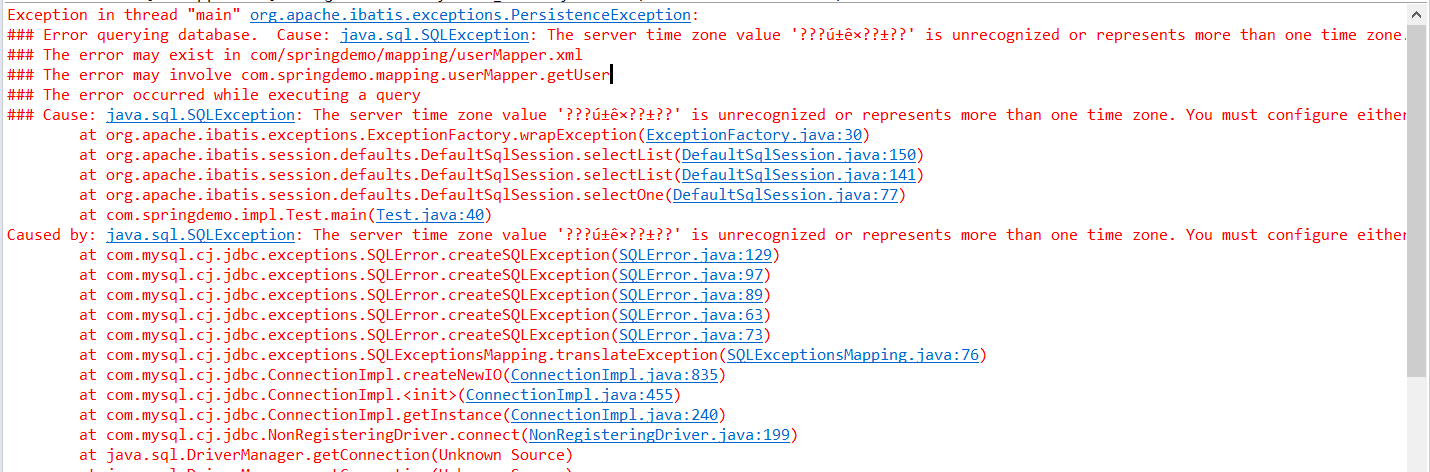

exceptions.ValueError: Missing scheme in request url: www.domain.com//bookstore/detail/3271993?alt=Something+I+Had+To+Do

任何人都可以让我知道为什么我收到此错误以及如何加入基本的URL与HREF链接,并产生一个请求