我是一个新人到Ubuntu,Hadoop和DFS,但我已经成功地张贴在这里Michael-Noll.com中的说明我的本地Ubuntu的机器上安装一个单节点的Hadoop实例:

http://www.michael-noll.com/tutorials/running-hadoop-on-ubuntu-linux-single-node-cluster/#copy-local-example-data-to-hdfs

http://www.michael-noll.com/tutorials/writing-an-hadoop-mapreduce-program-in-python/

我目前卡上运行的基本字数Hadoop的例子。 我不知道如果我一直在运行的Hadoop我的下载目录的事实使得太多的差别,但是我已经把他们atempted到tweek周围的mapper.py我的文件位置和reducer.py功能在没有成功的Hadooop工作目录。 我已经用尽了所有我的研究,仍然解决不了这个问题(即 - 使用-file参数等),我真的很感谢提前任何帮助,我希望我陷害的方式这个问题,它可以帮助其他人谁是刚刚开始使用Python + Hadoop的。

我测试了mapper.py和独立reduce.py,当与bash shell的玩具文本数据提示都工作得不错。

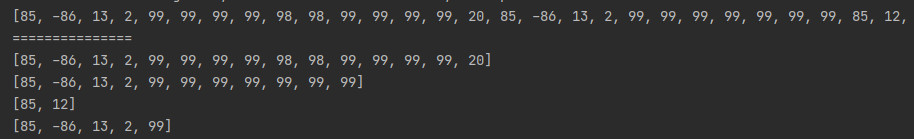

从我的Bash shell输出:

hduser@chris-linux:/home/chris/Downloads/hadoop$ bin/hadoop jar /home/chris/Downloads/hadoop/contrib/streaming/hadoop-streaming-1.0.4.jar -file mapper.py -file reducer.py -mapper mapper.py -reducer reducer.py -input /user/hduser/gutenberg/* -output /user/hduser/gutenberg-output3

Warning: $HADOOP_HOME is deprecated.

packageJobJar: [mapper.py, reducer.py, /app/hadoop/tmp/hadoop-unjar4681300115516015516/] [] /tmp/streamjob2215860242221125845.jar tmpDir=null

13/03/08 14:43:46 INFO util.NativeCodeLoader: Loaded the native-hadoop library

13/03/08 14:43:46 WARN snappy.LoadSnappy: Snappy native library not loaded

13/03/08 14:43:46 INFO mapred.FileInputFormat: Total input paths to process : 3

13/03/08 14:43:47 INFO streaming.StreamJob: getLocalDirs(): [/app/hadoop/tmp/mapred/local]

13/03/08 14:43:47 INFO streaming.StreamJob: Running job: job_201303081155_0032

13/03/08 14:43:47 INFO streaming.StreamJob: To kill this job, run:

13/03/08 14:43:47 INFO streaming.StreamJob: /home/chris/Downloads/hadoop/libexec/../bin/hadoop job -Dmapred.job.tracker=localhost:54311 -kill job_201303081155_0032

13/03/08 14:43:47 INFO streaming.StreamJob: Tracking URL: http://localhost:50030/jobdetails.jsp?jobid=job_201303081155_0032

13/03/08 14:43:48 INFO streaming.StreamJob: map 0% reduce 0%

13/03/08 14:44:12 INFO streaming.StreamJob: map 100% reduce 100%

13/03/08 14:44:12 INFO streaming.StreamJob: To kill this job, run:

13/03/08 14:44:12 INFO streaming.StreamJob: /home/chris/Downloads/hadoop/libexec/../bin/hadoop job -Dmapred.job.tracker=localhost:54311 -kill job_201303081155_0032

13/03/08 14:44:12 INFO streaming.StreamJob: Tracking URL: http://localhost:50030/jobdetails.jsp?jobid=job_201303081155_0032

13/03/08 14:44:12 ERROR streaming.StreamJob: Job not successful. Error: JobCleanup Task Failure, Task: task_201303081155_0032_m_000003

13/03/08 14:44:12 INFO streaming.StreamJob: killJob...

Streaming Command Failed!

我的HDFS位于/应用/ Hadoop的/ tmp目录它,我相信,也一样对我的Hadoop实例我/用户/ hduser目录。

输入数据位于/用户/ hduser /古滕贝格/ *(3 UTF纯文本文件)的输出被设定为/用户/ hduser /要创建古滕贝格输出