我试图建立蜂巢在Amazon的EMR从DynamoDB表中提取数据,并转储它S3。 我跟着上的说明, 在这里 ,并与我们的大多数表的成功。 随着一个DynamoDB表,但是,我得到一个错误(如下图所示)。

问题的表有很多列(> 100),和切割映射到只有其中的一个子集允许脚本运行,所以我假定这是问题,但我无法找到任何文件解决这个问题。

是否有某种硬性限制上我可以定义的列数? 或者是有,我很容易被击中这里一些其他的限制? 有没有办法解决呢?

我得到看起来像错误:

FAILED: Error in metadata: javax.jdo.JDODataStoreException: Put request failed : INSERT INTO `TABLE_PARAMS` (`PARAM_VALUE`,`TBL_ID`,`PARAM_KEY`) VALUES (?,?,?)

NestedThrowables:

org.datanucleus.store.mapped.exceptions.MappedDatastoreException: INSERT INTO `TABLE_PARAMS` (`PARAM_VALUE`,`TBL_ID`,`PARAM_KEY`) VALUES (?,?,?)

FAILED: Execution Error, return code 1 from org.apache.hadoop.hive.ql.exec.DDLTask

我试图运行脚本的样子:

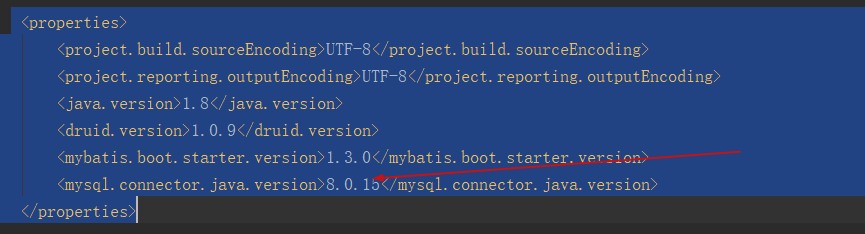

CREATE EXTERNAL TABLE hive_WSOP_DEV_STATS_input (col1 string, col2 string...)

STORED BY 'org.apache.hadoop.hive.dynamodb.DynamoDBStorageHandler'

TBLPROPERTIES ( "dynamodb.table.name" = "DYNAMO_TABLE_NAME",

"dynamodb.column.mapping" = "col1:col1,col2:col2...");